维谛UPS资讯

NEWS 更新时间:2023-02-08

更新时间:2023-02-08 点击次数:199

点击次数:199 根据工信部2019年的数据,截至2017年底,我国在用数据中心的机架总规模增长了33.4%,大型、超大型数据中心的规模增速达到68%[1]。根据国际环保组织绿色和平与华北电力大学发布的报告,2018年中国数据中心总用电量占中国全社会用电量的2.35%,未来5年数据中心总用电量将增长66%[2]。数据中心的电能消耗构成中,冷却系统约占40%。因此,降低冷却系统的能耗是实现数据中心节能减排的关键措施之一。

随着数据中心单机柜发热功率突破20kW,传统精密空调无法解决高功率、局部热点等问题,从而导致冷却系统运行能耗过高甚至出现无法完全散热的情况。浸没式液冷以其换热效率高的特点能够解决上述问题,被越来越广泛地运用。本文将重点介绍浸没式液冷的换热效率及节能潜力。

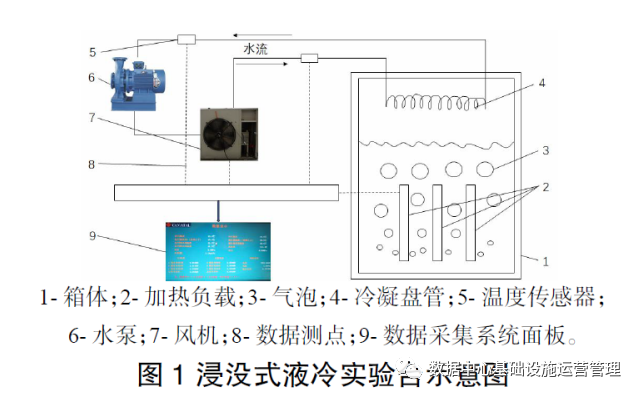

1.1 浸没式液冷实验台

实验台箱体及内部实验装置、数据采集装置均放置于室内侧环境舱,风机、水泵放置于室外侧环境舱,室内侧和室外侧环境舱均可用空调系统精确控制其空气参数。室内环境舱中尺寸为0.4m×1m×1.4m的箱体,加热负载位于箱体内中下部,冷凝盘管位于箱体上部。箱体内液体能完全浸没加热元件。箱体正面、右侧面和上表面均有部分区域用透明材料制成,方便实验人员观察箱体内实验情况。

1.2 浸没式液冷实验方法

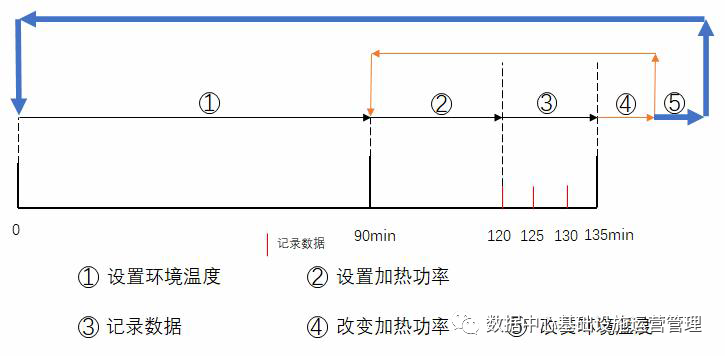

5)改变室外侧温度,重复上述14步,如图3示细箭头线。

图3 实验流程示意图

2.1 实验结果

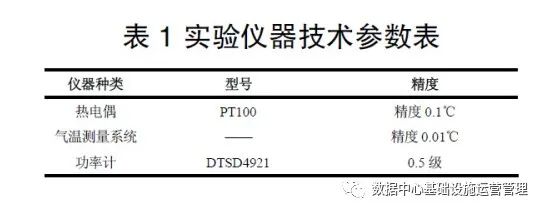

本实验记录了不同室外侧温度下的风机,水泵功率及负载加热功率。由于风机和水泵均为定频,其功率处在较小的区间内。风机功率稳定在145W,水 泵功率稳定在67W。相同室外侧温度下,负载加热功率由高到低调节,调节范围为0.8~3.8kW。

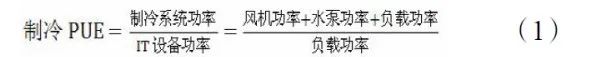

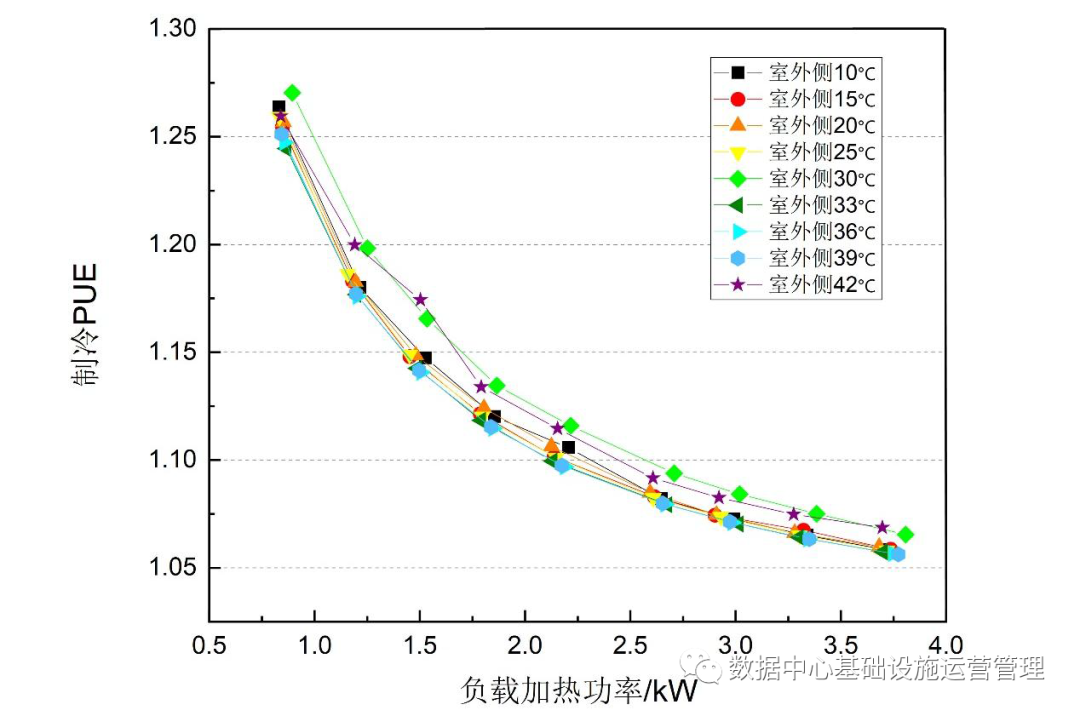

制冷PUE随负载加热功率的变化如图4,可以看出,制冷PUE值在1.05~1.28之间。制冷PUE定义为:

图4制冷PUE值随加热功率、室外侧温度的变化在不同室外侧温度下,制冷 PUE变化趋势呈现一致性,都是随负载加热功率的上升而降低。图4中制冷PUE最大值为1.270,对应室外侧30℃,负载功率0.895kW。最小值为1.056,对应室外侧39℃,负载功率3.773kW。

图5 室外侧温度42℃时,进口水温、出口水温、气体温度随加热功率的变化

2.2 全年制冷PUE计算

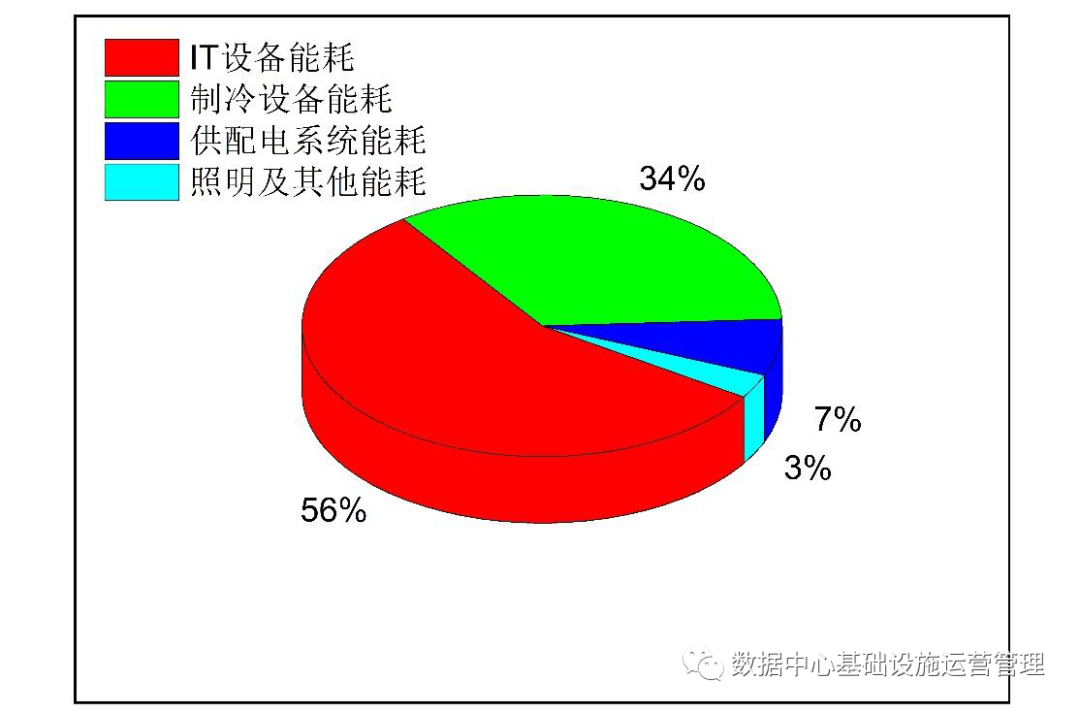

图6 使用传统精密空调的数据中心全年能耗比例

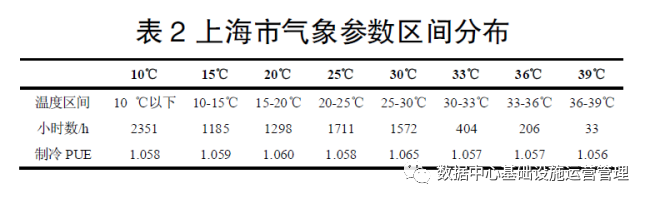

式中:下标i代表不同的天气区间;PUEi代表在该天气区间下的制冷PUE值;ni代表该天气下的小时数。

由式(3)得到上海地区全年制冷PUE为1.060,远低于论文中使用传统精密空调的数据中心全年制冷PUE-1.609,制冷能耗降低幅度高达90.2%。

3 结论

本文通过对浸没式液冷实验台进行测试,得出以下结论:

1)在不同室外侧温度、相同的发热功率下,制冷PUE值基本相同。

2)制冷PUE变化趋势呈现一致性,都是随负载加热功率的上升而降低。图中制冷PUE最大值为1.270,对应室外侧30℃,负载功率0.895kW时。最小值为1.056,对应室外侧39℃,负载功率3.773kW。

3)上海市使用浸没式液冷的数据中心其全年制冷PUE为1.060,相比于使用传统精密空调的数据中心,其制冷系统能耗降低了90.2%。

公司邮箱: admin@aimoshengups.net

服务热线: 13522046820

公司地址: 北京昌平区回龙观镇北清路1号

Copyright 2002-2013 北京维谛UPS电源维谛代理商 All rights reserved 本站为维谛经销商所有,非维谛官方网站